DIGITAL

BIG DATA

52

- ELETTRONICA OGGI 448 - SETTEMBRE 2015

che viene oggi definito come “machine

learning”.

In base a quanto fin qui schematizzato,

è possibile delineare quale può essere

una tipica sequenza di passi necessari

per attuare una corretta analisi e com-

prensione dei dati nell’ambito di quella

che viene comunemente definita la “data

science”. Il flusso di lavoro risultante po-

trebbe essere quello visibile in figura 1.

Per avere un’idea della mole di dati oggi

disponibile, si tenga conto che il volume

di dati digitali a livello mondiale eviden-

zia una crescita di tipo esponenziale,

pari a un incremento del 40-50% annuo

(Fig. 2). Si può affermare che il 90% dei

dati digitali che sono oggi in circolazio-

ne equivale a tutti i dati prodotti nei due

anni precedenti.

Data science e chip-maker

Vi è chi ritiene che, oggi, il rapido incremento dei dati digitali

costituisca un fattore di crescita tecnologico ampiamente sot-

tostimato, nel senso che i cosiddetti “connected devices” (dagli

smartphone ai tablet, dai “wearable” ai dispositivi per la comu-

nicazione dati nell’automobilistica, dalle webcam agli apparati

per telecomunicazioni) sono destinati a crescere dai 15 miliardi

attuali ai 50miliardi del 2020 (Fonte:

Cisco). Ed è anche grazie alla

diffusione e all’invasività di questi dispositivi che si deve il rapido

incremento nella mole dei dati oggi disponibili.

Molte sono le società di semiconduttori

presenti direttamente e indirettamente

nella realizzazione di componenti elet-

tronici utilizzati nei “connected devices”,

ovvero nei dispositivi che rientrano nel

concetto di IoT (Internet of Things). Si va

infatti dai microcontrollori ai dispositivi

per la comunicazione, dai processori

per segnali digitali ai sensori, dai display

alle memorie ad alta densità, dalle Dram

alle Flash.

Al di là dei chip utilizzabili nel settore

della IoT, comunque, vi sono dei dispo-

sitivi progettati per essere impiegati

specificatamente nel “big data proces-

sing”, e non si tratta solo di architetture

multiprocessore oppure di soluzioni di

memoria per l’accesso a grandi quantità

di dati, ma di chip di tipo programmabi-

le con architetture progettate ad hoc. Si

tratta delle logiche configurabili a eleva-

tissima densità (spesso denominate “Programmable System on

Chip”) quali quelle prodotte ad esempio da

Alterae

Xilinx

.

Il ruolo delle logiche programmabili

Recente è ad esempio l’accordo fra Altera e Baidu (il maggior

motore di ricerca online cinese) per l’impiego degli FPGA di Al-

tera e degli algoritmi CNN (Convolutional Neural Network) per

le applicazioni di “deep learning” focalizzate all’ottenimento di

ricerche online più accurate e più veloci. Il risultato di tale colla-

borazione è stato mostrato all’HPC dello scorso settembre a New

York, in relazione a compiti di classificazione e riconoscimento

di un elevato numero di immagini, quindi in un tipico ambito di

“heterogeneous computing”.

Si è constatato infatti che degli FPGA

(Field Programmable Gate Array) appo-

sitamente progettati e ottimizzati sono in

grado di permettere l’esecuzione degli

algoritmi CNN in maniera decisamente

più veloce rispetto ai processori tra-

dizionali, consentendo operazioni di

parallel-processing di elevata efficien-

za. I dispositivi ottimizzati per impieghi

di questo tipo sono gli FPGA Stratix V

(Fig. 3) e Arria 10 a cui faranno seguito

gli Stratix 10 e i nuovi SoC (System-on-

Chip) programmabili fabbricati utiliz-

zando il processo Intel Tri-Gate da 14

nanometri, che integrano logica riconfi-

gurabile, blocchi di IP, aree di memoria,

processori DSP e transceiver da oltre 28

Gbps. La stessa Altera ha altresì in esse-

re accordi con

Microsofte

Bingper un

progetto di accelerazione degli algorit-

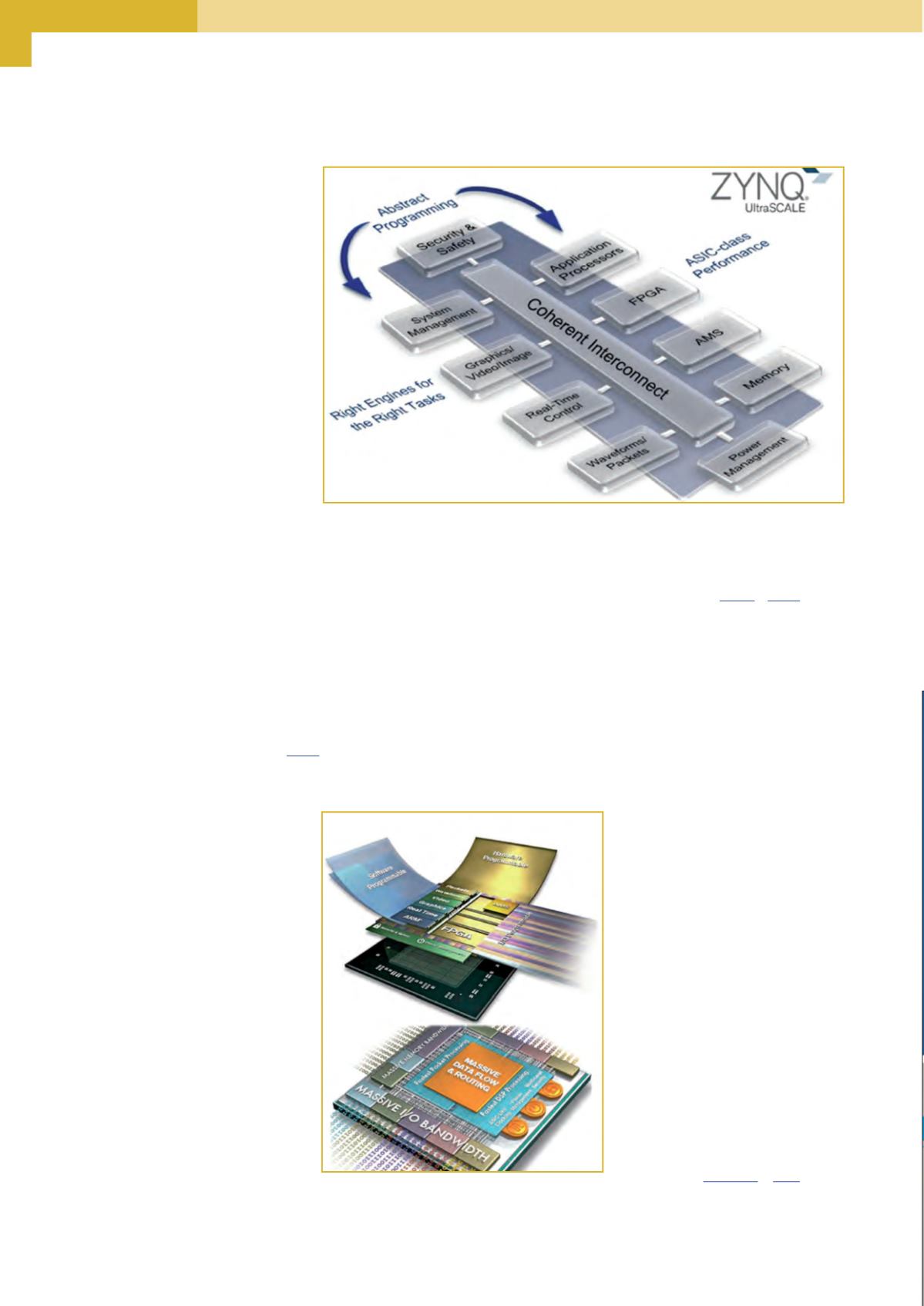

Fig. 5 – FPGA Xilinx della serie UltraScale Zinq-7000

Fig. 4 – Architettura dell’approccio “heterogeneous multiprocessing” di Xilinx