La Quarta Rivoluzione e il ruolo della DPU

I data center di ultima generazione comprendono sia le DPU che le CPU e le GPU. Cos’è una DPU? Perché sono vitali per la trasformazione digitale e la “quarta rivoluzione”?

Il termine CPU, abbreviazione di Central Processing Unit, esiste dagli anni ’50. Al centro di ogni computer o dispositivo intelligente si trova la CPU, che esegue le applicazioni tradizionali.

Dagli anni ’90 alla CPU si è affiancata la GPU, o Graphic Processing Unit, sviluppata per accelerare la grafica su schermo per le workstation di ingegneria, l’elaborazione video e il gaming, e per tenere il passo con le aspettative particolarmente elevate tipiche dell’occhio umano. Dobbiamo la nostra sopravvivenza alla nostra capacità di essere immediatamente all’erta al minimo movimento o anomalia visiva, e questo è sempre stato un problema per la progettazione degli schermi dei computer, il cinema e la televisione.

Infatti, mentre la CPU è progettata per elaborare un flusso lineare di dati, la GPU è progettata per elaborare un’esperienza multidimensionale che comprende lo spazio più le dimensioni del colore e del tempo. In teoria, anche la CPU potrebbe gestire tutto questo, ma in pratica risulterebbe troppo lenta e imprecisa.

L’aspetto più interessante della GPU è che questa capacità di elaborazione multidimensionale è molto vicina alle esigenze del machine learning e dell’elaborazione dei big data. Quello che è stato originariamente progettato per rendere più vivaci i giochi per computer è diventato una parte essenziale dei data center che sono alla base della trasformazione digitale.

Oggi sentiamo parlare molto di DPU, o Data Processing Unit. Ma le CPU e le GPU non sono già in grado di elaborare i dati? Qui, la differenza è legata non a quello che viene fatto, ma al modo in cui viene fatto. La DPU ha un ruolo fondamentale nella gestione del modo in cui i dati si muovono all’interno di un data center. E, ovviamente, integra la propria CPU.

Accelerazione attraverso una rete intelligente

Analizziamo una conferenza internazionale ad alto livello. Nell’interesse della trasparenza e dell’accuratezza le parole di ogni oratore dovrebbero essere trascritte nella lingua originale e passate agli altri partecipanti, che dovrebbero tradurre quelle esatte parole nella propria lingua. Ma non funziona così, perché vengono utilizzati interpreti che raccontano in tempo reale agli ascoltatori quello che viene detto, nella loro lingua. I traduttori hanno il tempo di studiare, mentre gli interpreti fanno il loro lavoro al volo.

Il ruolo di un interprete esperto non è solo quello di fornire una traduzione accurata, ma richiede altre competenze. Prima di tutto, la conoscenza dei termini nazionali: un australiano potrebbe usare la parola “mate” in modo amichevole, mentre l’interprete sa che è meglio sostituire “mate” con “Vostra Altezza”. Poi c’è la comprensione delle frasi tipiche di una cultura – l’inglese dice “it is not cricket” – un’espressione che potrebbe risultare poco chiara per le altre persone.

Poi c’è la necessità di accelerare la comunicazione modificando “hum” ed “er”, pause drammatiche e aneddoti personali sconclusionati. Ci può anche essere una sottile codifica: i “nostri concorrenti europei” possono diventare i “nostri alleati europei”. Infine, nell’interesse della pace e della sicurezza globale, alcuni enunciati potrebbero essere semplicemente dimenticati.

Sintetizzando, un team di abili interpreti può fare in modo che i messaggi essenziali vengano trasmessi ai destinatari nella forma più sintetica, mantenendo il controllo sui messaggi negativi. I delegati evitano un mal di testa per la traduzione e il protocollo, e possono concentrarsi meglio sulla diplomazia di alto livello.

In un data center tradizionale la rete non è altro che una serie di cavi collegati da switch che distribuiscono i dati da e verso le CPU, dove avviene tutta l’elaborazione. In un data center moderno, la rete è collegata attraverso DPU che elaborano i dati al volo per ridurre il carico sulle CPU e lasciargli la gestione delle applicazioni. Di fatto, esse svolgono un ruolo non dissimile da quello di un team di interpreti molto professionali. Quindi cosa c’è nella DPU?

La DPU

La DPU è una nuova tipologia di processore programmabile, un SOC (System-on-Chip) che abbina tre elementi:

- Una CPU multi-core di tipo standard, ad alte prestazioni, programmabile via software.

- Un’interfaccia di rete ad alte prestazioni in grado di analizzare, elaborare e trasferire i dati in modo efficiente, alla velocità della rete.

- Un ricco set di motori di accelerazione flessibili e programmabili, progettati per scaricare (offload) i compiti di rete e ottimizzare le prestazioni delle applicazioni di AI e Machine Learning, sicurezza, telecomunicazioni e archiviazione, ecc.

Questo terzo componente è particolarmente significativo, perché può essere confrontato con le competenze dell’interprete perfetto che è stato appena descritto: un insieme di funzioni che servono a ottimizzare l’efficienza, e far sì che i dati giusti vadano nel formato giusto al posto giusto lungo il percorso più veloce e affidabile. Può anche supportare la crittografia, oltre a identificare il traffico anomalo o il malware, e persino avviare una risposta adeguata.

Alcuni fornitori di DPU si affidano a processori proprietari, mentre altri si aspettano che la CPU faccia tutto il lavoro, ma a meno che non siano presenti i tre elementi di cui sopra, il dispositivo non dovrebbe essere chiamato DPU.

La DPU, di solito, è integrata in un controller di interfaccia di rete (NIC) per creare quello che viene chiamato uno SmartNIC: un componente chiave dei data center di prossima generazione, quello che alimenta la rivoluzione dei dati definita come la “Quarta Rivoluzione”.

La Quarta Rivoluzione

Alcuni storici hanno individuato tre rivoluzioni chiave nell’evoluzione dell’umanità:

- La Rivoluzione Cognitiva, intorno al 70.000 a.C., che ha definito la nascita del linguaggio e la capacità di comunicare.

- La rivoluzione agricola, intorno al 10.000 a.C., che ha definito la nostra capacità di addomesticare gli animali da allevamento e coltivare le colture per sostenere l’ascesa delle città.

- La Rivoluzione Scientifica, durante il primo periodo moderno, che ha gettato le basi – con lo sviluppo della matematica, della fisica, dell’astronomia e delle scienze – per il nostro stile di vita moderno.

La quarta rivoluzione è l’intelligenza artificiale (IA), in grado di svolgere compiti con livelli di prestazione che vanno oltre l’umano. L’apprendimento automatico avanzato oggi è in grado di organizzare, elaborare ed estrarre informazioni quasi impercettibili ma preziose dall’enorme mole di dati generati da milioni di utenti su Internet e dalla diffusione di IoT. Un passo fondamentale in direzione dello sviluppo di una vera intelligenza artificiale e delle straordinarie possibilità che questo consente.

Anche in presenza delle GPU che elaborano i dati, l’evoluzione viene comunque frenata dal fatto che le CPU devono accedere alle informazioni e condividerle tra i computer, continuando ad alimentare le GPU con i dati.

Un passaggio fondamentale è stato quello di rendere la rete ancora più veloce, ma questo ha ulteriormente “appesantito” la CPU, gravandola di compiti relativi alla gestione dei dati. Ora con le DPU viene conferito un livello di intelligenza maggiore alla rete, proprio come quel team di interpreti molto professionali, trasformando la rete in un “agente attivo” nell’elaborazione complessiva dei dati. Le DPU avvicinano l’elaborazione ai dati stessi e fanno sì che la rete agisca come un co-processore che scarica il lavoro dall’engine di calcolo centrale.

La Trasformazione Digitale è l’applicazione commerciale della Quarta Rivoluzione: questo è il motivo per cui presto sentiremo parlare sempre di più delle DPU.

Foto in apertura: I differenti ruoli di CPU, GPU e DPU

Kevin Deierling VP Marketing NVIDIA Business Networking Unit

Contenuti correlati

-

Vertiv collabora con NVIDIA per la piattaforma GB200 NVL72

Vertiv ha realizzato, in collaborazione con NVIDIA, una nuova architettura di riferimento da 7MW. Questa nuova architettura, che supporta fino a 132kW per rack, ha l’obiettivo di accelerare l’implementazione della piattaforma rack-scale NVIDIA GB200 NVL72 raffreddata a...

-

La diffusione dell’intelligenza artificiale

L’intelligenza artificiale generativa sta trovando applicazione in un numero sempre maggiore di settori e i produttori si stanno adeguando rapidamente con l’introduzione di soluzioni sempre più innovative e pervasive Leggi l’articolo completo su EO518

-

Nuova collaborazione tra Cohesity e NVIDIA

Cohesity ha annunciato una collaborazione con NVIDIA per aiutare le organizzazioni a usare la Generative AI utilizzando i microservizi NVIDIA NIM e integrando NVIDIA AI Enterprise nella Cohesity Gaia platform. Le iniziative di raccolta fondi messe in...

-

Top ten semicoduttori: Intel riconquista la vetta

Secondo i risultati preliminari forniti da Gartner, il fatturato mondiale dei semiconduttori nel 2023 ammonta a 533 miliardi di dollari, con un calo dell’11,1% rispetto al 2022. “Il mercato ha vissuto un anno difficile, con il fatturato...

-

Il metaverso visto da Siemens

Il metaverso industriale costituisce un cambio di paradigma, e permetterà alle organizzazioni di usare gli ambienti virtuali per trasformare radicalmente la gestione delle proprie operation. Di questo argomento abbiamo parlato con Franco Megali, VP & CEO Italy,...

-

GPU: uno sguardo in profondità

Le attuali GPU sono molto diverse dai primi modelli e hanno raggiunto livelli di complessità molto elevati, necessari per supportare una serie articolata di applicazioni non solo nel settore della grafica Leggi l’articolo completo su EO 513

-

Gli acceleratori hardware

L’implementazione di acceleratori è ormai imprescindibile per molte applicazioni e i vantaggi di queste soluzioni sono indispensabili non soltanto per migliorare le prestazioni ma anche per ridurre i consumi e i costi Leggi l’articolo completo su EO...

-

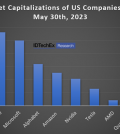

Capitalizzazione di mercato record per Nvidia

La società di ricerche di mercato IDTechEx ha recentemente pubblicato un rapporto che evidenzia il costante predominio di Nvidia non soltanto nel settore delle GPU, ma più specificamente anche in quello dell’hardware per AI. Nvidia, inoltre, martedì...

-

Rohde & Schwarz presenta con NVIDIA un ricevitore neurale per 6G basato su AI/ML

È stata scelta la cornice del MWC di Barcellona per la prima dimostrazione “hardware-in-loop”, da parte di Rohde & Schwarz e NVIDIA, di un ricevitore neurale che evidenzia i guadagni di prestazioni ottenibili, per la tecnologia 6G,...

-

Analisi di mercato in tempo reale su GPU NVIDIA per Mediobanca

Le capacità di calcolo delle GPU NVIDIA sono utilizzate anche da Mediobanca per le sue esigenze di elaborazione accelerata. Il calcolo ad alte prestazioni infatti è particolarmente importante per le banche d’investimento i cui servizi prevedono transazioni...