Elaborazione a elevate prestazioni

Dalla rivista:

Elettronica Oggi

Nel bollettino ufficiale della Digital Agenda for Europe (DAE) della CEE datato il 15 febbraio di quest’anno si legge che l’High Performance Computing (HPC) è da considerarsi una risorsa critica per le industrie europee poiché consente di sviluppare tecnologie a elevatissimo valore aggiunto che possono rivelarsi preziose per migliorare la bilancia commerciale del Vecchio Continente verso l’Asia e l’America.

Oggi nel termine HPC si intendono sia i supercomputer progettati con a bordo un po’ di CPU integrate insieme allo scopo di eseguire un gran numero di operazioni al secondo sia i cluster costituiti da reti di PC realizzate appositamente per implementare tecniche di calcolo parallelo in condivisione delle risorse fra i processori disponibili in rete. Questi cluster sono, in pratica, dei supercomputer distribuiti che sfruttano i recenti progressi compiuti dalle tecnologie di cloud computing, le quali consentono oggi di sfruttare Internet per distribuire fra un’infinità di risorse dislocate nell’intero pianeta qualsiasi tipologia di problema da risolvere, senza più bisogno di disporre di quanta più intelligenza possibile a livello locale dato che ce n’è all’infinito in condivisione delle risorse.

Interessante a tal proposito è una recente ricerca del MIT che dimostra che i bus singoli all’interno dei moderni chip multicore conservano il massimo delle prestazioni solo fino a 4 core CPU, mentre da 8 core CPU in su perdono efficienza e le prestazioni migliorano solo se s’implementano almeno due bus di sistema. La stessa proporzione resta valida all’aumentare del numero delle CPU e si dimostra che le massime prestazioni si ottengono solo aumentando anche il numero dei bus in misura adeguata. Da ciò la ricercatrice Peh del MIT deduce che quando i core CPU diventano troppi sono e saranno sempre più competitive le architetture dove le risorse sono distribuite e questo concetto rimane valido se invece di considerare core multipli interconnessi a bus multipli si considerano i numerosi core CPU distribuiti in rete delle architetture cluster.

Nel comunicato DAE viene specificato che il cloud computing ossia la condivisione dei contenuti software in rete e il loro utilizzo su hardware di elaborazione a elevate prestazioni è un’opportunità “indispensabile per le imprese europee per rinnovarsi, competere e sopravvivere” e non solo per quelle medie e grandi che hanno più possibilità d’investire in ricerca e sviluppo, ma anche per le piccole imprese che possono fruire delle nuove tecnologie per delineare strategie di mercato mirate ad applicazioni specifiche. Secondo l’Unione Europea l’HPC permette di sviluppare soluzioni innovative per accelerare e rendere più affidabili e produttive attività di business che prima erano riservate a risicate élite di laboratori di ricerca consentendo a tutti di contribuire a migliorare la redditività delle applicazioni notoriamente a più elevato costo come, per esempio, il progetto dei nuovi autoveicoli, le previsioni meteorologiche o l’assistenza decisionale ai medici nelle operazioni chirurgiche.

Prospettive condivise

Nel recente studio IBM “The Power of Cloud: Driving business model innovation” si legge che “il cloud computing non comporta solamente un miglioramento di efficienza e un risparmio complessivo dei costi, ma permette anche di stimolare l’innovazione che costituisce un vantaggio competitivo sul mercato”. Ciò significa che le nuove tecnologie di cloud computing implementate su computer a elevate prestazioni hanno le carte in regola per stimolare la nascita di nuove tendenze nell’economia globale. Da parte sua, la Commissione Europea ha istituito il consorzio PRACE, Partnership for Advanced Computing in Europe, fra i laboratori di ricerca delle principali università comunitarie con la missione di sviluppare collaborazioni mirate con i laboratori delle industrie europee al fine di valutare l’utilità delle tecnologie di HPC nelle applicazioni e nelle due varianti oggi più ricorrenti ossia gli HPC Load Balancing e gli HPC High Availability laddove i primi sono progettati per fare in modo di dare più lavoro alla CPU che di volta in volta ne ha di meno, mentre i secondi sono impostati sulla priorità di garantire sempre la massima offerta di risorse fra quelle disponibili in tempo reale.

Nel comunicato DAE si osserva altresì che attualmente un supercomputer costa circa un centinaio di milioni di euro oltre a una decina di milioni di mantenimento annuale, ed è considerato HPC se le sue prestazioni sono nell’ordine del PetaFlops (milioni di miliardi di operazioni in virgola mobile al secondo) ossia quanto circa centomila PC da tavolo. I pochi attualmente già installati sono usati per predire l’evoluzione di sistemi a elevata complessità in medicina, in economia e nello sviluppo delle nuove tecnologie. L’HPC può essere un’alternativa e un’opportunità per ridurre i costi dei supercomputer grazie alla miglior redditività dei cluster. Il report pubblicato da IDC all’HPC User Forum svoltosi a Richmond in Virginia a metà aprile dice che i computer HPC sono cresciuti nel 2011 dell’8,4% e quindi ben oltre il 7,2% previsto nel report precedente e, inoltre, dovrebbero continuare a crescere con una media del 7,6% all’anno per i prossimi tre anni. Tuttavia, nel comunicato DAE si legge anche che oggi sono i laboratori americani e nipponici a sfornare il maggior numero di brevetti malgrado in Europa vi siano le menti più illustri sia nello sviluppo degli algoritmi software sia nel disegno dei circuiti integrati a semiconduttore. Si tratta, dunque, di un gap che potrebbe essere facilmente superato se i laboratori europei decidessero di cooperare un po’ di più e se ci fosse la volontà di spingere in questo nuovo settore di mercato.

Inoltre, un importante ritorno delle tecnologie HPC è già stato misurato in termini di sostenibilità giacché un qualsiasi sistema di calcolo in condivisione delle risorse in rete consente di risparmiare energia fino a un centinaio di volte rispetto all’equivalente parco di PC singoli che occorrerebbe altrimenti utilizzare per svolgere le stesse elaborazioni. In questo senso si rivolge anche l’Action Plan for European Leadership in HPC decretato in ambito europeo per spingere le imprese comunitarie a “essere protagoniste nelle grandi sfide sociali e scientifiche come la diagnosi precoce e la cura delle malattie come il morbo di Alzheimer, lo studio dell’evoluzione del clima o la prevenzione e la gestione delle catastrofi su vasta scala”.

Qualche novità sul mercato Aethia di Colleretto Giacosa vicino a Ivrea è impegnata nel settore degli HPC da oltre un decennio e oggi propone computer cluster HPC in configurazione LB e HA oltre alla piattaforma software completa HPC Suite dotata di tutti gli strumenti necessari per configurare e utilizzare al meglio i sistemi cluster. Aethia fornisce anche il software Beolive specifico per la gestione delle piattaforme di PC multipli in rete e realizza hardware preconfigurati nella forma di reti di PC o sistemi di calcolo multiprocessore pronti all’uso e facilmente installabili in qualsias

Aethia di Colleretto Giacosa vicino a Ivrea è impegnata nel settore degli HPC da oltre un decennio e oggi propone computer cluster HPC in configurazione LB e HA oltre alla piattaforma software completa HPC Suite dotata di tutti gli strumenti necessari per configurare e utilizzare al meglio i sistemi cluster. Aethia fornisce anche il software Beolive specifico per la gestione delle piattaforme di PC multipli in rete e realizza hardware preconfigurati nella forma di reti di PC o sistemi di calcolo multiprocessore pronti all’uso e facilmente installabili in qualsias

i ambiente applicativo.

I sistemi cluster HPC Aethia permettono di realizzare reti di computer in condivisione delle risorse di semplice configurazione e utilizzo

I server possono altresì appoggiarsi a reti di storage distribuite e a workstation che Aethia prepara appositamente al supporto dei cluster sfruttando l’impostazione open-source di Linux. I cluster HPC sono rilasciati “chiavi in mano” con tutto ciò che serve sia hardware sia software al funzionamento e alla manutenzione della rete di calcolo distribuita. Ogni sistema Aethia è scalabile e può essere adattato alle applicazioni o espanso all’aumentare delle esigenze di rete, ma sempre con la massima semplicità d’uso da parte dell’utente.

Eurotech ha ricevuto questa primavera un ordine di 1,2 milioni di Euro da parte del Forschungszentrum Jülich, uno dei più grandi centri di ricerca europei, per la fornitura di un sistema HPC della famiglia Aurora che sarà utilizzato nel progetto dell’Unione Europea denominato DEEP, Dynamic Exascale Entry Platform, finalizzato alla ricerca e alla sperimentazione di un super HPC europeo in grado di raggiungere gli ExaFlops ossia un miliardo di miliardi di calcoli in virgola mobile al secondo e cioè almeno un migliaio di volte più potente rispetto al più veloce supercomputer attualmente esistente.

Eurotech ha ricevuto questa primavera un ordine di 1,2 milioni di Euro da parte del Forschungszentrum Jülich, uno dei più grandi centri di ricerca europei, per la fornitura di un sistema HPC della famiglia Aurora che sarà utilizzato nel progetto dell’Unione Europea denominato DEEP, Dynamic Exascale Entry Platform, finalizzato alla ricerca e alla sperimentazione di un super HPC europeo in grado di raggiungere gli ExaFlops ossia un miliardo di miliardi di calcoli in virgola mobile al secondo e cioè almeno un migliaio di volte più potente rispetto al più veloce supercomputer attualmente esistente.

Eurotech ha particolarmente curato l’efficienza energetica dei suoi sistemi HPC Aurora che sono in grado di offrire 900 MegaFlops/Watt

Il nuovo HPC sarà realizzato come un cluster di core CPU organizzati e gestiti da un innovativo acceleratore condiviso chiamato Booster che ne aumenterà la potenza di calcolo consentendo una scalabilità senza precedenti. L’ultimo nato nella famiglia Aurora è l’HPC 10-10 basato sui processori Intel Xeon E5-2687W con frequenza di lavoro di 3,1 GHz ciascuno e offre prestazioni che globalmente superano i 100 TeraFlops con un’efficienza energetica quantificata in 900 MegaFlops/Watt.

Fujitsu Italia ha ultimato lo sviluppo dei server Primergy x86 predisposti per essere utilizzati in cluster nelle applicazioni SMP, Symmetric Processing, high-end negli ambienti HPC, High Performance Computing. Grazie alla certificazione vSMP Foundation i server Primergy sono utilizzabili per creare cluster a memoria condivisa senza bisogno di costose soluzioni software proprietarie.

Fujitsu Italia ha ultimato lo sviluppo dei server Primergy x86 predisposti per essere utilizzati in cluster nelle applicazioni SMP, Symmetric Processing, high-end negli ambienti HPC, High Performance Computing. Grazie alla certificazione vSMP Foundation i server Primergy sono utilizzabili per creare cluster a memoria condivisa senza bisogno di costose soluzioni software proprietarie.

I server Fujitsu Primergy x86 sono utilizzabili in cluster SMP HPC con fino a 1024 core CPU e memoria condivisa fino a 64 TeraByte

La tecnologia ScaleMP consente, infatti, di supportare le applicazioni multi-threaded a elevate prestazioni basate su Open MultiProcessing e di scalare in un unico cluster virtuale fino a ben 1024 processori con fino a 64 TeraByte di memoria condivisa. Fujitsu propone uno stack HPC completo che va dalle soluzioni basate su workstation Celsius fino alle soluzioni a elevate prestazioni Primergy certificate e pronte all’uso senza bisogno di particolari competenze e disponibili anche custom per applicazioni specifiche. L’ultimo nato è il Primergy CX400 S1 basato sui core Intel Xeon E5-2600 e definito “multi-node cloud extension server” o “4in2U” perché offre in un rack 2U le prestazioni tipicamente disponibili nei contenitori 4U.

Nvidia ha recentemente presentato il processore grafico GPU Tesla K10 specificatamente pensato per le applicazioni di High Performance Computing nel supporto dei sistemi per l’elaborazione dei dati di immagini complesse per applicazioni nei settori medicale, militare e aerospaziale.

Nvidia ha recentemente presentato il processore grafico GPU Tesla K10 specificatamente pensato per le applicazioni di High Performance Computing nel supporto dei sistemi per l’elaborazione dei dati di immagini complesse per applicazioni nei settori medicale, militare e aerospaziale.

I processori grafici GPU Tesla K10 e K20 sfruttano l’architettura HPC Kepler capace di eseguire ben 4,58 TeraFlops

Nel silicio della GPU Tesla K10 Nvidia ha integrato due core di calcolo GK104 Kepler capaci di eseguire ben 4,58 TeraFlops in singola precisione e indirizzare i dati in memoria al ritmo di 320 GByte al secondo. Ancor più potente sarà la GPU Tesla K20 che Nvidia sta ultimando con a bordo due core GK110, ma questo core HPC è atteso verso la fine di quest’anno. L’architettura Nvidia Kepler ha un’innovativa concezione dello streaming multiprocessore che consente d’impiegare maggiormente i core di elaborazione rispetto alla logica di controllo massimizzando l’efficienza di calcolo algebrico e, inoltre, i core sono strutturati per eseguire rapidamente i loop in parallelo grazie all’interconnessione Hyper-Q che riduce il tempo d’inattività dei singoli core.

Lucio Pellizzari

Contenuti correlati

-

Vertiv collabora con NVIDIA per la piattaforma GB200 NVL72

Vertiv ha realizzato, in collaborazione con NVIDIA, una nuova architettura di riferimento da 7MW. Questa nuova architettura, che supporta fino a 132kW per rack, ha l’obiettivo di accelerare l’implementazione della piattaforma rack-scale NVIDIA GB200 NVL72 raffreddata a...

-

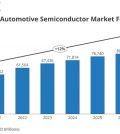

IDC: crescita rilevante per i ricavi dei semiconduttori per automotive

IDC prevede una crescita particolarmente elevata a livello globale per i semiconduttori dedicati al settore automotive. Secondo i dati del Worldwide Semiconductor Automotive Ecosystem and Supply Chain di IDC, infatti, è verosimile una domanda sempre maggiore di...

-

La diffusione dell’intelligenza artificiale

L’intelligenza artificiale generativa sta trovando applicazione in un numero sempre maggiore di settori e i produttori si stanno adeguando rapidamente con l’introduzione di soluzioni sempre più innovative e pervasive Leggi l’articolo completo su EO518

-

Nuova collaborazione tra Cohesity e NVIDIA

Cohesity ha annunciato una collaborazione con NVIDIA per aiutare le organizzazioni a usare la Generative AI utilizzando i microservizi NVIDIA NIM e integrando NVIDIA AI Enterprise nella Cohesity Gaia platform. Le iniziative di raccolta fondi messe in...

-

La tecnologia rugged e l’operatività in una ricerca commissionata da Getac

Getac Technology ha annunciato i risultati del report che ha commissionato ad IDC dal titolo ” Redefining Total Cost of Ownership: Rugged Technologies to Empower Industrial Operation “, April 2024. Le principali attività per cui vengono utilizzati...

-

L’ispezione visiva industriale potenziata dall’Edge AI

L’introduzione dell’Edge AI nell’ispezione visiva ha aperto nuove opportunità e vantaggi per l’industria Leggi l’articolo completo su Embedded 91

-

Top ten semicoduttori: Intel riconquista la vetta

Secondo i risultati preliminari forniti da Gartner, il fatturato mondiale dei semiconduttori nel 2023 ammonta a 533 miliardi di dollari, con un calo dell’11,1% rispetto al 2022. “Il mercato ha vissuto un anno difficile, con il fatturato...

-

Il metaverso visto da Siemens

Il metaverso industriale costituisce un cambio di paradigma, e permetterà alle organizzazioni di usare gli ambienti virtuali per trasformare radicalmente la gestione delle proprie operation. Di questo argomento abbiamo parlato con Franco Megali, VP & CEO Italy,...

-

GPU: uno sguardo in profondità

Le attuali GPU sono molto diverse dai primi modelli e hanno raggiunto livelli di complessità molto elevati, necessari per supportare una serie articolata di applicazioni non solo nel settore della grafica Leggi l’articolo completo su EO 513

-

Eurotech tra le aziende top nella classifica per le piattaforme IoT

techconsult ha classificato Eurotech come “Champion”. Questa valutazione della società di ricerca e analisi industriale, con sede in Germania, si basa sui risultati del sondaggio tra gli utenti “PUR – Engineering Solutions” (Professional User Rating) di techconsult....