TECH INSIGHT

NEWS/ TECHNOLOGIES

27

- ELETTRONICA OGGI 466 - NOVEMBRE/DICEMBRE 2017

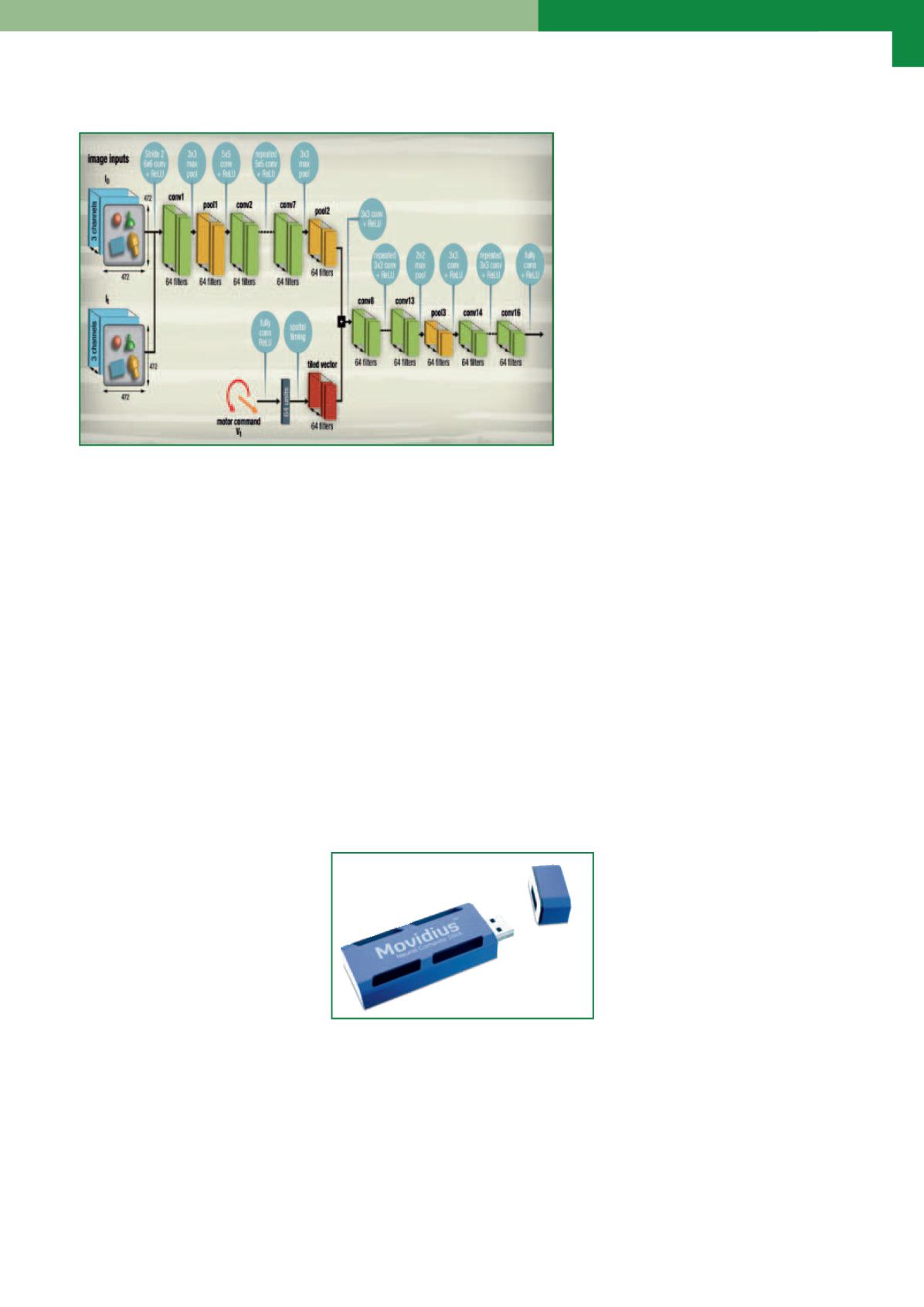

gle su questo esperimento è intitolato “Le-

arning Hand-Eye Coordination for Robotic

Grasping with Deep Learning and Large-

Scale Data Collection”). Ovviamente, que-

sta strada non è perfetta, basti pensare

per esempio ai tempi ancora necessari per

l’apprendimento e, per contro, alle neces-

sità di ridurre i tempi per rendere operati-

vo un robot per applicazioni produttive. É

vero che le macchine possono apprende-

re in modo più veloce degli esseri umani,

ma alcuni analisti ritengono che, ancora

per qualche tempo, un sistema che preve-

da una programmazione fissa potrà essere

più efficiente per la produzione rispetto a

uno dotato di autoapprendimento. Non va

trascurato comunque che i tempi di autoapprendimento necessari all’implementazione del deep learning si possono

ridurre utilizzando i database di dimensioni sempre maggiori, che sono sempre più spesso disponibili. Quello produt-

tivo, inoltre, è soltanto uno degli ambiti in cui le reti neurali e il deep learning possono dimostrarsi utili. Questo spiega

perché gli investimenti in questo settore stanno crescendo in modo esponenziale.

Chiavetta USB per progetti di deep

learning a consumi bassissimi

Alessandro Nobile

D

isponibile in un comodo formato USB, Intel Movidius Neural Compute Stick (NCS) è uno strumento di sviluppo

a bassissimo consumo per l’inferenza del deep learning. Commercializzato da

RS Components

, questo disposi-

tivo consente di sviluppare e prototipare applicazioni di intelligenza artificiale (IA)per un’ampia gamma di dispositivi

di ultima generazione. Destinato a sviluppatori, ricercatori R&D aziendali e universitari che utilizzano applicazioni

di machine-learning e data-science,

il Neural Compute Stick integra il

processore VPU (Vision Processing

Unit) Movidius che offre un’efficien-

za energetica ottimale ed è in grado

di gestire reti neurali convoluzionali

(CNN) in virgola mobile a prestazio-

ni elevate. Il Neural Compute Stick,

che supporta il noto framework Caf-

fe per le reti neurali profonde (DNN),

è lo strumento di sviluppo ideale per

la prototipazione e l’accelerazione

di reti neurali. Il motore inferenziale

consente a sviluppatori e ricercatori

di gestire i progetti al di fuori del

cloud e di comprendere velocemen-

te le prestazioni e la precisione del-

le proprie applicazioni di reti neurali

che operano nel mondo reale. I pro-

getti di reti neurali possono essere

velocemente trasferiti mediante il

Movidius Neural Compute Compiler

per gestire l’inferenza del deep lear-

ning in tempo reale sulla chiavetta

USB compatta. L’NCS, adatto per

l’accelerazione delle piattaforme

esistenti con capacità di elabora-

zione limitata, consente la R&D e la

prototipazione del deep learning su un laptop Linux o su un dispositivo host basato su x86. Inoltre la API della Neu-

ral Compute Platform consente alle applicazioni degli utenti di girare su un host embedded che può inizializzare la

piattaforma target, caricare un file grafico o ‘scaricare’ le inferenze. In futuro è previsto un ampliamento del supporto

dell’NCS che comprenderà anche altre piattaforme (es. Raspberry Pi). L’elenco completo degli strumenti software

disponibili nel Movidius Neural Compute Software Development Kit comprende il Movidius Neural Compute toolkit e

la Movidius Neural Compute API. Questi strumenti sono disponibili online sul sito

developer.movidius.com.Architettura del CNN grasp predictor dell’esperimento di Google

Fonte: Google

Movidius Neural Compute Stick è un piccolo disposi-

tivo senza ventola prodotto da Intel per sviluppare e

prototipare applicazioni di intelligenza artificiale (IA)