TECH INSIGHT

VISIONE ARTIFICIALE

16

- ELETTRONICA OGGI 465 - OTTOBRE 2017

La progettazione dei sistemi

basati sulla visione artificiale

Parte 6 –

La fusione efficiente dei sensori nei sistemi di visione embedded sofisticati

La presente serie di articoli ha considerato diversi aspetti dello

sviluppo di sistemi di visione embedded, inclusa la scelta dei sensori,

l’interfacciamento e lo sviluppo della catena del segnale che comprende

gli algoritmi di elaborazione dei segnali visivi

A cura di Xilinx

I

n un’applicazione di visione embedded sofisticata, come ad esempio un sistema avanzato di guida Assistita

(ADAS), alcune funzionalità potrebbero dipendere dalla combinazione dei risultati provenienti da due o più

sensori. Questa è la sensor fusion, e consente al sistema di acquisire informazioni che non possono essere for-

nite da un singolo sensore. Nel contesto dei sistemi di visione, la sensor fusion è generalmente effettuata in tem-

po reale, per consentire

decisioni in tempo reale.

L’alternativa è la fusio-

ne offline dei sensori,

in cui i dati del senso-

re sono estratti e fusi e

le decisioni vengono

prese in un momento

successivo. In più, in

un’applicazione come

un ADAS, la sensor fu-

sion potrebbe compor-

tare la combinazione di

numerosi canali di dati

fra sensori dello stesso

tipo, o potrebbe richie-

dere la fusione di dati

provenienti da diversi

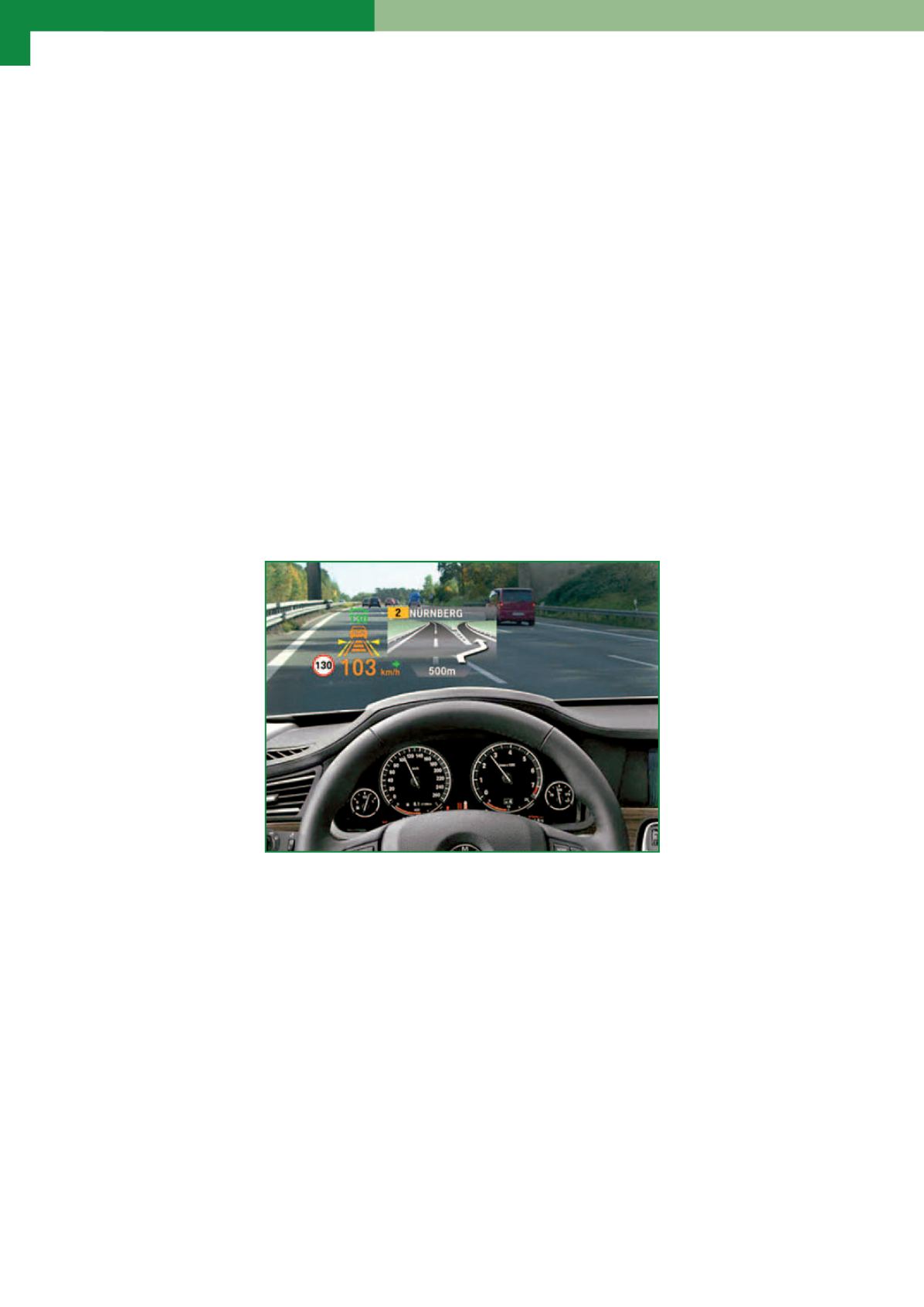

tipi di sensori. Un’appli-

cazione di rilevazione

degli oggetti e di moni-

toraggio delle distanze

(Fig. 1) fornisce un buon

esempio per confronta-

re questi approcci, omo-

geneo ed eterogeneo,

alla fusione dei sensori.

Un sistema che si basa

su un singolo senso-

re di visione anteriore

potrebbe individuare e

identificare degli ogget-

ti, ma è necessario alme-

no un ulteriore sensore

di visione per calcolare

le distanze allo scopo di

individuare gli oggetti usando un algoritmo per il calcolo della parallasse. In alternativa, è possibile ottenere la

combinazione delle funzioni di rilevazione, riconoscimento degli oggetti e determinazione della distanza fon-

dendo i dati dei sensori di visione con dei RADAR o LIDAR. Altri esempi di applicazione implicano la fusione di

diversi tipi di immagini che includono i raggi X, la MRI e la CT per le applicazioni medicali, o le immagini visibili

e all’infrarosso nei sistemi di sicurezza.

Requisiti di elaborazione

Effettuare calcoli sui dati provenienti da più sensori di visione richiede una potenza di calcolo considerevole. Se

si usano i sensori di immagini a colori, sono richieste operazioni di elaborazione di pre-fusione, come l’interpola-

zione del filtro di colore, la conversione nello spazio di colore, il ricampionamento e la correzione dell’immagine.

L’algoritmo di fusione dei sensori deve essere eseguito, e un sistema ADAS richiede una successiva sottrazione

dello sfondo, una definizione delle soglie e la rilevazione dei contorni per localizzare gli oggetti usando l’approc-

cio più semplice, mentre alcuni sistemi potrebbero usare anche un classificatore HoG/SVM, caratterizzato da

un’intensità di elaborazione più elevata. Inoltre, l’esigenza di ottenere velocità di trasmissione dei fotogrammi

superiori o dimensioni maggiori delle immagini accresce ulteriormente la potenza di calcolo richiesta per pre-

elaborare le immagini e per estrarre le informazioni.

Fig. 1 – ADAS con funzioni di visione che richiede la sensor fusion