45

IoT |

hardware

EMBEDDED

57 • SETTEMBRE • 2015

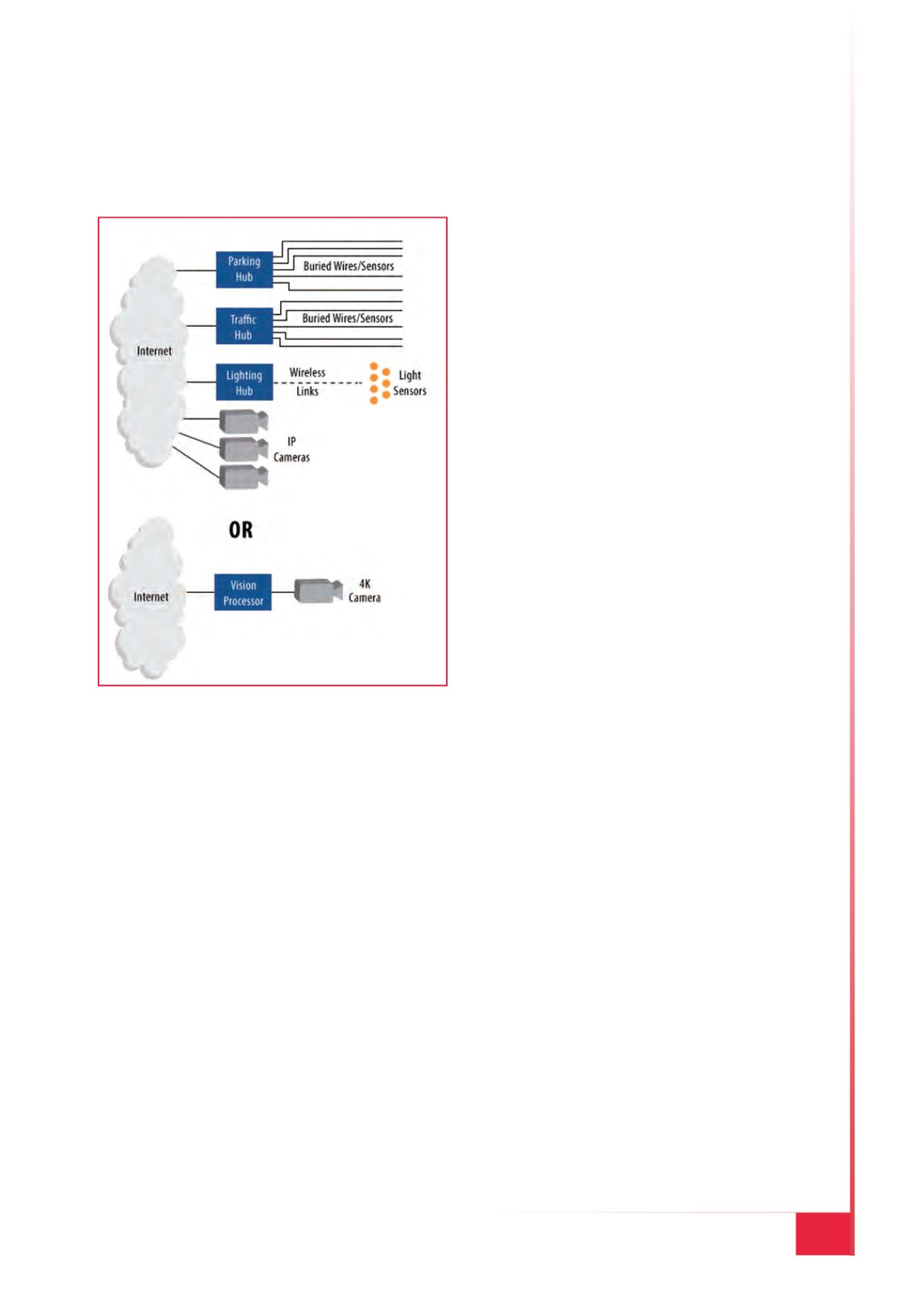

che usano collegamenti wireless dalle sommità

dei lampioni verso i rispettivi hub.

Esiste comunque un’altra possibilità. Un osser-

vatore “intelligente”, visionando i filmati pro-

venienti da alcune telecamere di sicurezza, po-

trebbe individuare facilmente quali sono i lam-

pioni accesi, quali sono i parcheggi occupati e il

momento in cui le luci dei semafori dovrebbero

cambiare. Il risultato finale sarebbe una drasti-

ca riduzione del TCO (Total Cost of Ownership

– ovvero il costo totale di possesso), a fronte di un

aumento dell’affidabilità e dell’aggiunta di fun-

zionalità di salvaguardia e sicurezza che non sa-

rebbero stato possibile implementare con l’utiliz-

zo di un gran numero di semplici sensori (Fig. 1).

Concetti simili a quelli appena esposti possono

essere applicati ad altre tipologie di sistemi. Gli

stimatori di stato che utilizzano modelli mate-

matici computazionali dei sistemi sono in grado

di calcolare la posizione di un albero motore a

partire dai valori di corrente e tensione degli av-

volgimenti del motore come pure lo stato di una

reazione chimica in base a osservazioni fatte

dall’esterno. In generale, la tendenza prevalente

prevede l’impiego di un numero ridotto di senso-

ri remoti – molto spesso telecamere – supportati

da risorse di elaborazione piuttosto che un gran

numero di sensori che possono far insorgere pro-

blemi in termini di consumi, connettività, affida-

bilità e sicurezza.

Cambiamenti radicali

L’idea di sostituire algoritmi di elaborazione

particolarmente onerosi – come ad esempi reti

neurali convoluzionali o filtri di Kalman – per

reti di sensori semplici comporta da un lato ovvi

vantaggi, ma pone dall’altro anche alcuni pro-

blemi. I progettisti si trovano quindi di fronte

a un dilemma. È meglio preservare lo spirito

proprio della virtualizzazione trasferendo i dati

originali – che possono essere più flussi di video

con risoluzione 4K – al cloud oppure mettere a

disposizione elevate risorse di elaborazione in

prossimità dei sensori? Entrambi gli approcci

evidenziano pregi e difetti.

L’elaborazione a livello di cloud ha indubbi van-

taggi. In primo luogo si può disporre senza pro-

blemi di tutta la potenza di calcolo necessaria.

Nel caso inoltre si volessero sperimentare algo-

ritmi per analizzare i big data (in pratica tutte

quelle raccolte di dataset che presentano 3 ca-

ratteristiche peculiari, le cosiddette 3V: volume,

velocità, varietà), lo spazio di memorizzazione

a disposizione è pressoché illimitato. Il terzo

vantaggio è rappresentato dal fatto che l’utente

paga praticamente solamente ciò che utilizza. A

tutti questi vantaggi si accompagnano una serie

di problematiche in termini di sicurezza, latenza

e ampiezza di banda. Se l’algoritmo che si inten-

de utilizzare è “intollerante” alla latenza, l’unica

via percorribile è ricorrere all’elaborazione loca-

le. Nel caso invece sia ammessa una certa laten-

za tra l’ingresso dei dati provenienti dai sensori

e la risposta del sistema, il problema diventa

quello di stabilire l’entità di questa latenza e la

variazione ammissibile.

Alcuni algoritmi di controllo, ad esempio, pos-

sono supportare tempi di latenza significativi

all’interno di un un loop a condizione che la la-

tenza sia quasi costante. Problemi di questo tipo

non rappresentano un grosso ostacolo quando

la quantità di dati che viene trasferita verso il

Fig. 1 – Una singola telecamera può essere in

grado di acquisire un maggior numero di dati