TECH INSIGHT

SWaP-C

22

- ELETTRONICA OGGI 460 - MARZO 2017

tipici sensori di immagini a colori. Gli spazi di colore

più comunemente usati all’interno dei sistemi di visio-

ne embedded sono:

•

Rosso, Verde, Blu (RGB) – Questo spazio di colori

contiene l’informazione RGB così come è prodotta

dal sensore di immagini, ed è comunemente usato

come un’uscita per interfacce semplici come la VGA.

•

YUV – Quest’ultimo contiene le informazioni di lumi-

nanza (Y) e di crominanza (U & V), ed è usato nella

maggior parte dei codec e in alcuni standard di di-

splay. I formati comunemente usati sono YUV4:4:4 e

YUV4:2:2. Con il formato 4:4:4 ciascun pixel è rappre-

sentato da otto bit realizzando un pixel da 24 bit. Con

un formato 4:2:2 i valori U e V sono condivisi fra i pixel,

consentendo di ottenere una profondità di pixel da 16

bit più efficiente in termini di occupazione di memoria.

Un’ulteriore decisione che ha un impatto considerevole

sulla catena di elaborazione dell’immagine e sullo SWaP-

C è la scelta di dove realizzare la maggior parte dell’ela-

borazione dell’immagine. Quest’ultima può avere luogo

all’interno dello stesso sistema di visione, il che consen-

te di ottenere una risposta più rapida, ma richiede anche

risorse maggiori di elaborazione e di memoria, portando

a requisiti maggiori di potenza. Quest’ultimo sarà l’ap-

proccio più comune per le applicazioni embedded come

i sistemi ADAS o di visione artificiale.

In alternativa, l’esecuzione dell’elaborazione su cloud

richiede che il sistema di visione embedded sia in gra-

do di catturare l’immagine e di trasmetterla usando la

tecnologia basata su rete. Questo approccio è adatto

per applicazioni quali l’elaborazione delle immagini

medicali o la ricerca scientifica, in cui l’elaborazione

può essere molto intensa e non sono richiesti risultati

in tempo reale.

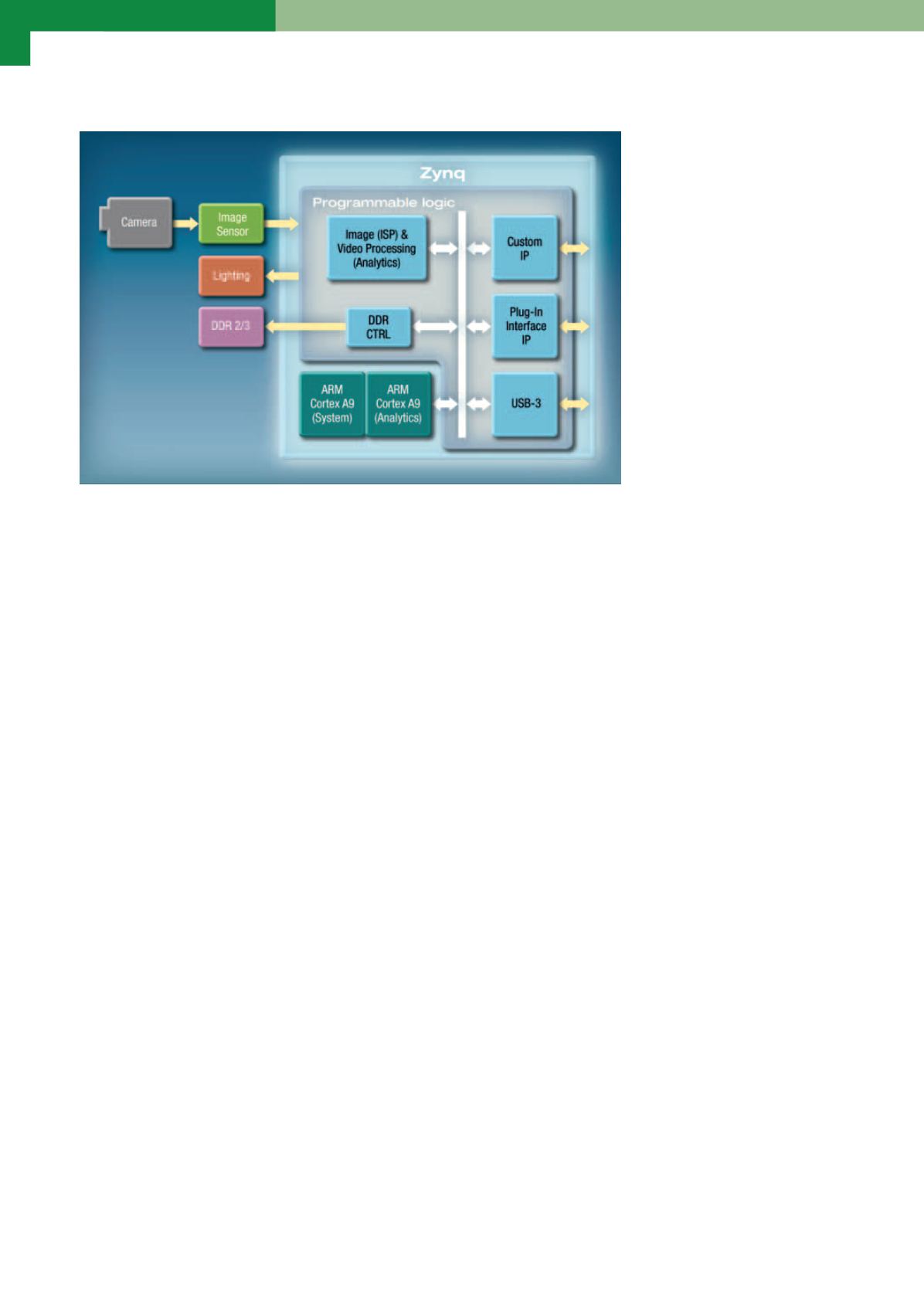

Per realizzare la catena di

elaborazione, il cuore di un

sistema di visione embedded

richiede un’unità di elabo-

razione che sia in grado non

solo di controllare il sensore

di immagini selezionato, ma

anche di ricevere, eseguire

la sequenza di elaborazione

delle immagini e trasmettere

queste ultime su un’infrastrut-

tura di rete o al display sele-

zionato. Tali requisiti esigenti

spesso portano a scegliere un

FPGA o, come avviene nella

maggior parte dei casi, un Sy-

stem-on-a-Chip Interamente

Programmabile.

I SoC Interamente Program-

mabili Zynq di Xilinx combi-

nano due processori ARM A9 ad alte prestazioni con

una matrice FPGA. Il sistema di elaborazione (PS) può

essere usato per comunicare con un host attraverso

Gigabit Ethernet, PCIe o altre interfacce come CAN,

effettuando anche al contempo attività generali di ge-

stione ordinaria del sistema. La sezione a logica pro-

grammabile (PL) sfrutta la natura parallela della ma-

trice FPGA per ricevere ed elaborare le immagini in

modo estremamente efficiente.

Se le immagini devono essere trasmesse su rete, è pos-

sibile usare i controllori su chip per l’accesso diretto

alla memoria (DMA) per spostare in modo efficiente i

dati di immagine dalla logica programmabile alla me-

moria DDR del PS. Una volta all’interno della memoria

DDR del sistema di elaborazione, è possibile accedere

ai dati anche usando i controllori DMA del supporto

selezionato per il trasporto dei dati. Vale la pena di

notare che i processori A9 possono essere usati per

effettuare ulteriori elaborazioni sull’immagine all’inter-

no della DDR del PS, e che l’architettura Zynq consen-

te anche di spostare le immagini elaborate all’interno

della catena di elaborazione dalla DDR del PS alla PL,

assicurando così la massima flessibilità nella scelta

della strategia di elaborazione più efficiente.

La figura 2 illustra la stretta integrazione fra l’elabora-

zione, il controllo della memoria e le funzioni di inter-

faccia all’interno del dispositivo Zynq.

In conclusione, seguendo le linee guida sulla scelta

del sensore fornita nella prima parte della presente

serie di approfondimenti, questo articolo ha descrit-

to numerose tecnologie, ambienti e dispositivi che

possono essere usati per aiutare a soddisfare vincoli

stringenti di dimensioni, peso, consumo di potenza e

costi (SWaP-C) relativi ai sistemi di visione embedded

per applicazioni particolarmente impegnative.

Fig. 2 – Risorse di elaborazione delle immagini nei SoC Interamente Programmabili Zynq