EMBEDDED

63 • FEBBRAIO • 2017

54

HARDWARE

|

AUTOMOTIVE

re in modo autonomo, ma anche di raggiungere le de-

stinazioni previste senza interazione alcuna da parte

del conducente, è divenuto più chiaro grazie al lavoro

condotto a livello sia nazionale sia internazionale da

ricercatori e legislatori.

Assicurare il più elevato livello di sicurezza per

l’utilizzatore è una priorità assoluta ed è

appunto in questa direzione che la tecno-

logia sta evolvendo. I sistemi avanzati di

ausilio al guidatore (ADAS – Advanced

Driver Assist System) rappresentano solo

l’inizio: la vera rivoluzione si concretizzerà

solamente nel momento in cui sarà possibi-

le conferire doti di “intelligenza” e intero-

perabilità a tali sistemi.

Le piattaforme richieste per garantire un

tale livello di autonomia sono già disponi-

bili. I continui progressi nel campo delle

architetture di elaborazione, uniti alle nu-

merose iniziative nel settore del software

open source, stanno contribuendo a tramu-

tare questa visione in una realtà concreta.

Un impatto su larga scala

Non vi è dubbio che i veicoli autonomi sono

destinati a diventare una realtà all’ordine

del giorno sulle strade di tutto il mondo.

Questo fenomeno non riguarderà solamen-

te le auto familiari in grado di parcheggia-

S

u un fatto analisti ed Enti governativi con-

cordano: i veicoli autonomi sono destinati a diventa-

re una consuetudine sulle nostre strade in un futuro

abbastanza prossimo. Il percorso evolutivo da seguire

per arrivare a questo nuovo modello di riferimento,

dove i veicoli non solo saranno in grado di parcheggia-

La guida autonoma richiede

sistemi di visione “intelligenti”

I sistemi di visione intelligenti implementati sfruttando

una combinazione di piattaforme di elaborazione

avanzate come i SoC della serie G di AMD supportati

da un completo ecosistema software saranno

un elemento di fondamentale importanza nello sviluppo

di veicoli completamente autonomi

Lars Asplund

Fredrik Bruhn

Unibap AB

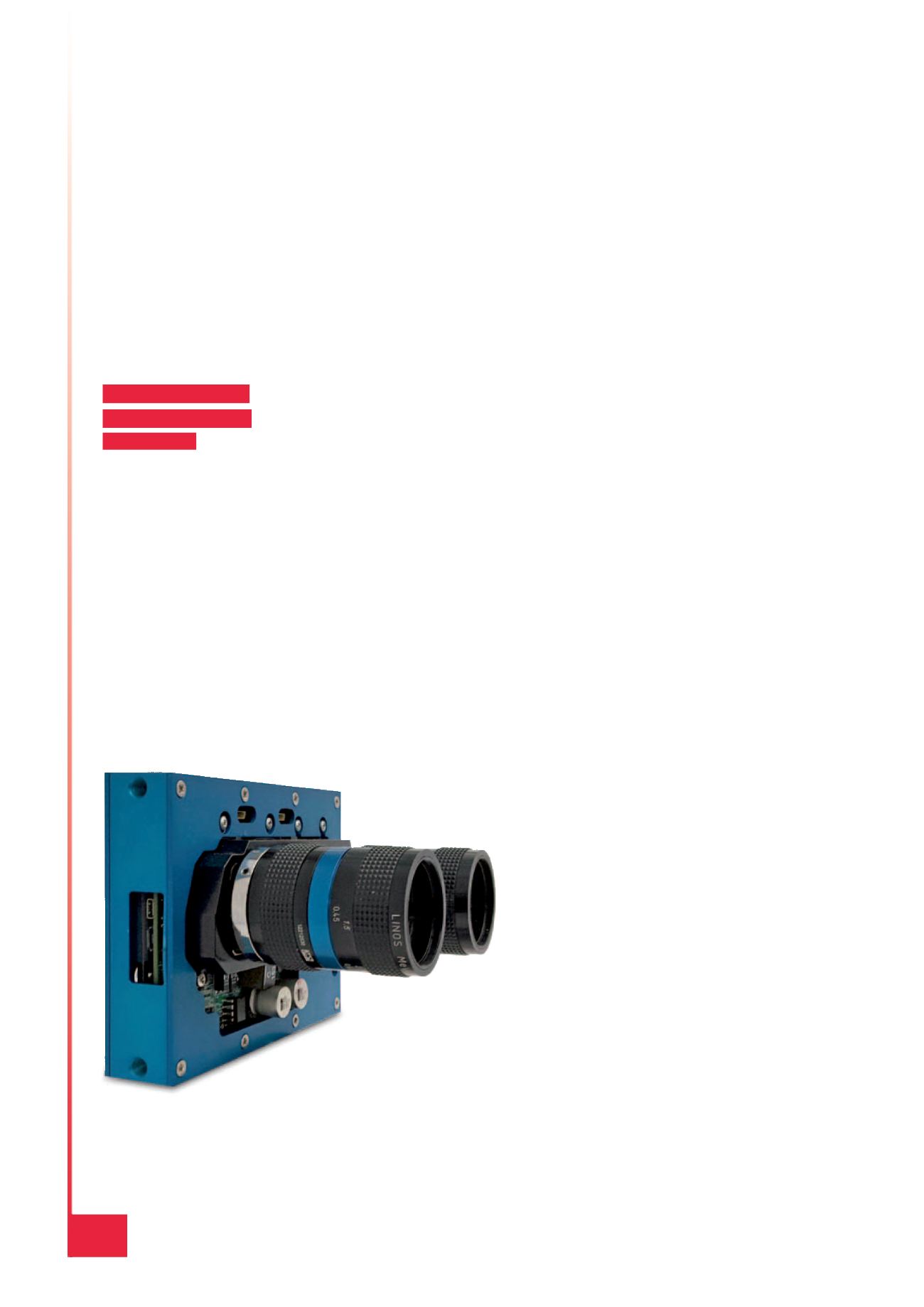

Fig. 1 – I sistemi di visione intelligenti come quello svilup-

pato da Unibap sono in grado di acquisire e identificare

i più piccoli cambiamenti che si verificano nel campo vi-

sivo per ogni singolo frame. Si tratta di una funzionalità

cruciale per raggiungere il Livello 4 della scala definita da

NHTSA relativa ai veicoli autonomi